¿Esta siendo usada tu PC sin que lo sepas en la actual guerra digital?.

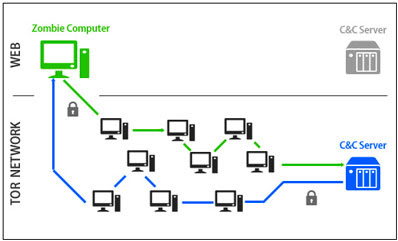

Ya con anterioridad había comentado sobre la guerra cibernética que se libra a nivel mundial desde hace años y más aun, el peligro latente de que nuestras PC´s sean usadas como botnet o atacantes cibernéticos sin nuestro conocimiento. Cuando la luz de nuestro disco duro parpadea sin cesar sin que estemos haciendo nada con ella o la luz del router titila aun cuando supuestamente no hay trafico en a red, es hora de averiguar lo que pasa con nuestra PC ya que puede ser victima de una intrusión y ser parte de una red botnet como le ha pasado a un amigo que me pidió el favor de revisarle su PC por que la notaba rara y sorpresa cuando me encontré que estaba siendo usada remotamente para realizar ataques.

Eventos recientes demuestran que la guerra es real y se incrementa cada día.

A mediados del pasado mes de marzo, diversas organizaciones experimentaron un ataque distribuido de denegación de servicio. Esto, desde luego, no es noticia, es algo que ocurre con una frecuencia diaria, por diferentes motivos, sobre objetivos dispares y usando técnicas que sabríamos reconocer al instante conociendo ciertos detalles. Este ataque en concreto, se diferencia en la infraestructura usada como apoyo para generar el tráfico de ataque. Un uso orquestado de recursos con una precisión y capacidad de maniobra fuera del alcance del perfil atacante al que estamos acostumbrados. Veamos que hay detrás del apodado recientemente "Gran cañón de China".

Martes, 17 de marzo

Los administradores del sitio greatfire.org reciben un tráfico de 2.600 millones de visitas. Cae el sitio principal y todos los espejos que mantiene la organización a lo largo de Internet. Según ellos mismos, los servicios alojados en la nube de Amazon les generan un cargo de 30.000 dólares cada día. Algo insostenible para una

organización sin ánimo de lucro, creada para evadir la censura impuesta en China a ciertos sitios y servicios de Internet que son agregados a su lista negra.

Jueves, 26 de marzo

Cae github.com. En una breve entrada en el blog corporativo github comunica que está recibiendo "el mayor ataque distribuido de denegación de servicio en la historia de github.com". En la entrada ya señalan que, conjuntamente a los vectores conocidos, observan "una sofisticada técnica que usa el navegador web de usuarios de manera inadvertida" para generar tráfico masivo sobre sus servidores. Segúngithub.com el ataque es una "invitación" para que retiren cierto contenido, sin señalar el qué y a quien le resulta molesto. El equipo de seguridad Google sugiere http://googleonlinesecurity.blogspot.com.es/2015/04/a-javascript-based-ddos-attack-as-seen.html

que el contenido podría ser este: https://github.com/greatfire

. Es evidente la relación con el primer ataque.

Cómo fabricar un ejército de un millón de máquinas

Tradicionalmente se ha recurrido a la infección de sistemas de escritorio, servidores comprometidos o sitios web a los que se les ha añadido código javascript malicioso. En cualquier caso, el paso previo para añadir un elemento a la incauta red de trasvase de tráfico involuntario era recurrir a la intrusión o infección masiva de sistemas. Todas esas molestias pueden ser evitadas si dispones de la infraestructura adecuada.

En los ataques observados, los navegadores de los usuarios cargaban código javascript que aparentemente procedía de baidu.com, el mayor buscador chino y uno de los sitios con mayor tráfico de toda la red. No era necesario visitar baidu.com, bastaba hacerlo a cualquier sitio web, dentro o fuera de China, que hiciese uso del sistema de análisis de visitas de Baidu, quien por cierto niega completa y rotundamente cualquier responsabilidad en los ataques. ¿Entonces como llegó ese contenido a los navegadores de los usuarios?

Gigante en el medio

De sobra conocido, el gran cortafuegos chino nace en 1998, bajo el nombre en código de "Escudo dorado", entrando en estado operacional en 2003. Este descomunal proyecto permite al gobierno chino "desconectar" selectivamente aquellos sitios o servicios que son considerados subversivos o contrarios a la moralidad. Para dicha tarea es necesario contar con una infraestructura controlada y supervisada. Pensemos en la dificultad para establecer este tipo de controles en una empresa de tamaño mediano y después hagamos los cálculos para hacer lo mismo en el país más poblado del mundo.

Todos y cada uno de los datagramas IP que entran o salen de China son examinados por el escudo dorado. Aquellos que son marcados como contenido subversivo o de origen sospechoso son manipulados para cerrar la conexión de inmediato, las peticiones DNS son controladas para redirigir los dominios prohibidos y todo el texto no cifrado es sistemáticamente analizado en busca de elementos problemáticos. Solo el cifrado (y no en todos los casos) permite abrir una pequeña brecha para evadir la censura.

Según el estudio técnico publicado por Citizenlab https://citizenlab.org/2015/04/chinas-great-cannon/

, esa misma tecnología de inspección de paquetes fue usada para insertar el contenido malicioso, que era devuelto a los clientes que solicitaban ciertos recursos a Baidu, durante la ventana de ataque. Denominan a dicha infraestructura el "Gran cañón de China" y la asocian directamente al "Gran cortafuegos chino", luego por definición están señalando al gobierno chino como responsable de los ataques dirigidos.

El esquema de ataque se reducía a observar el tráfico, detectar si el recurso se estaba pidiendo a un dominio controlado por Baidu e inyectar un script malicioso de manera aleatoria al tráfico saliente de los servidores hacia el cliente. Estos últimos, se encargaron de generar miles de millones de visitas a los sitios afectados.

El código del script contenía URL pertenecientes a la infraestructura de Amazon, usada por GreatFire. Posteriormente dichas URLs fueron sustituidas por las atacadas a Github: github.com/greatfire y github.com/cn-nytimes.

¿Y el tráfico cifrado?

Podríamos pensar que si establecemos un canal seguro entre nuestro cliente y cualquier recurso, en este caso cualquier subdominio debaidu.com, nos va a proteger ante la inyección de contenido en el canal, evitando la manipulación. ¿Nos va a proteger el cifrado?

La siguiente captura de pantalla pertenece al repositorio de certificados de la última versión de Firefox, lo mismo ocurre para el llavero del sistema operativo. Esta captura y estos https://blog.mozilla.org/security/2015/04/02/distrusting-new-cnnic-certificates/

enlaces http://googleonlinesecurity.blogspot.co.nz/2015/03/maintaining-digital-certificate-security.html?m=0

podránhttps://en.greatfire.org/blog/2015/mar/evidence-shows-cnnic-and-cac-behind-mitm-attacks

despejar cualquier duda ante la pregunta. Tráfico cifrado no significa que sea seguro, simplemente significa que está…cifrado.

Más información:

Cómo proteger mejor su PC con protección botnet y evitar el malware

http://www.microsoft.com/es-xl/security/pc-security/botnet.aspx

A Javascript-based DDoS Attack as seen by Safe Browsing

http://googleonlinesecurity.blogspot.com.es/2015/04/a-javascript-based-ddos-attack-as-seen.html

China’s Great Cannon

https://citizenlab.org/2015/04/chinas-great-cannon/

Distrusting New CNNIC Certificates

https://blog.mozilla.org/security/2015/04/02/distrusting-new-cnnic-certificates/

Maintaining digital certificate security

http://googleonlinesecurity.blogspot.co.nz/2015/03/maintaining-digital-certificate-security.html?m=0

Evidence shows CNNIC and CAC behind MITM attacks

https://en.greatfire.org/blog/2015/mar/evidence-shows-cnnic-and-cac-behind-mitm-attacks